1. 네트워크의 기초

1.1. 네트워크란?

네트워크는 컴퓨터 등의 장치들이 통신 기술을 이용하여 구축하는 연결망을 지칭하는 용어이자

네트워크란 노드(node)와 링크(link)가 서로 연결되어 있거나 연결되어 있지 않은 집합체를 의미한다.

노드: 서버, 라우터, 스위치 등 네트워크 장치를 의미.

링크: 노드간 연결된 유선 또는 무선을 의미

1.2. 처리량과 지연 시간

처리량: 링크를 통해 전달되는 단위 시간당 데이터 양을 말한다. 단위로는 bps(bits per second)

처리량은 사용자들이 많이 접속할 때마다 커지는 트래픽, 네트워크 장치 간의 1. 대역폭, 네트워 크 중간에 발생하는 2.에러, 장치의 3. 하드웨어 스펙에 영향을 받는다.

+a) 용어정리

대역폭: 주어진 시간 동안 네트워크 연결을 통해 흐를 수 있는 최대 비트 수

트래픽: 특정 시점에 링크 내에 흐르는 데이터의 양

지연시간: 요청이 처리돼서 돌아오는 시간

지연 시간은 1. 매체 타입(무선, 유선), 2. 패킷 크기, 3. 라우터의 패킷 처리 시간에 영향을 받는다.

<주요 차이점>

트래픽이 많아졌다 = 흐르는 데이터가 많아졌다

처리량이 많아졌다= 처리되는 트래픽이 많아졌다

1.3. 네트워크 토폴로지와 병목 현상

네트워크 토폴로지(network topology)는 노드와 링크가 어떻게 배치되어 있는지에 대한 방식이자 연결 형태

크게 5가지로 트리, 버스, 스타, 망, 메시 형태가 있다.

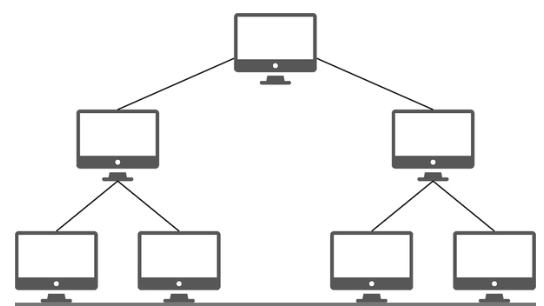

1. 트리 토폴리지: 계 층형 토폴로지라고 하며 트리 형태로 배치한 네트워크 구성

장점: 노드의 추가, 삭제가 쉽다.

단점: 특정 노드에 트래픽이 집중될 때 하위 노드에 영향을 끼칠 수 있다.

2. 버스 토폴로지: 중앙 통신 회선 하나에 여러 개의 노드가 연결되어 공유하는 네트워크 구성을 말하며 근거리 통신망(LAN)에서 사용

장점: 설치 비용이 적고 신뢰성이 우수하며 중앙 통신 회선에 노드를 추가하거나 삭제하기 쉽다.

단점: 스푸핑이 가능한 문제점이 있다.

+a) 용어정리

스푸핑: LAN상에서 송신부의 패킷을 송신과 관련 없는 다른 호스트에 가지 않도록 하는 스위칭 기능을 마비시키거나 속여서 특정 노드(원하는 노드)에 해당 패킷이 오도록 처리하는 것을 말한다.

그림처럼 스푸핑을 적용하면 올바르게 수신부로 가야 할 패킷이 악의적인 노드에 전달되게 된다.

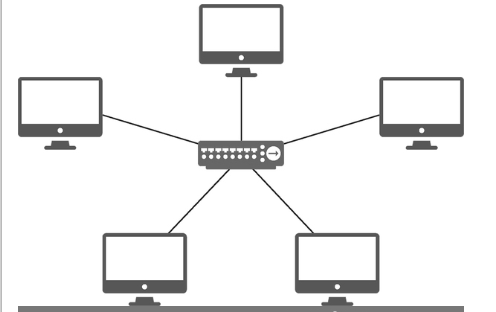

3. 스타 토폴로지: 스타(star, 성형) 토폴로지는 중앙에 있는 노드에 모두 연결된 네트워크 구성을 말한다.

장점: 노드를 추가하거나 에러를 탐지하기 쉽고 패킷의 충돌 발생 가능성이 적다. 또한, 어떠한 노드에 장애가 발생해도 쉽게 에러를 발견할 수 있으며 장애 노드가 중앙 노드가 아닐 경우 다른 노드에 영향을 끼치는 것이 적다.

단점: 중앙 노드에 장애가 발생하면 전체 네트워크를 사용할 수 없고 설치 비용이 고가입니다.

4. 링형 토폴로지: 각각의 노드가 양 옆의 두 노드와 연결하여 전체적으로 고리처럼 하나의 연속된 길을 통해 통신을 하는 망 구성 방식.

장점: 노드 수가 증가되어도 네트워크상의 손실이 거의 없고 충돌이 발생되는 가능성이 적고 노드의 고장 발견을 쉽게 찾을 수 있다.

단점: 네트워크 구성 변경이 어렵고 회선에 장애가 발생하면 전체 네트워크에 영향을 크게 끼치는 단점이 있다.

5. 메시 토폴로지: 메시(mesh) 토폴로지는 망형 토폴로지라고도 하며 그물망처럼 연결되어 있는 구조

장점: 여러개의 경로가 존재하여, 장애가 발생해도 네트워크를 계속 사용할 수 있으며, 트래픽 분산처리가 가능하다.

단점: 노드의 추가가 어렵고 구축 비용과 운용비용이 고가이다.

병목현상

토폴로지가 중요한 이유: 병목 현상을 찾고, 이를 해결함에 있어 중요한 방식을 찾을 수 있다.

위의 그림과 같이 버스형태의 토폴로지에 대역폭을 늘려도 병목현상이 해결되지 않을 수 있다. 물론 대역폭 자체를 늘리는 방식은 비용도 매우 증가 한다. 하지만 여기에 버스에 회선을 추가함으로써 하나의 회선에만 발생하는 병목현상을 해결할 수 있다.

1.4. 네트워크 분류

네트워크는 규모를 기반으로 분류한다.

1. LAN (Local Area Network): 사무실과 개인적으로 소유 가능

- 근거리 통신망을 의미하며 같은 건물이나 캠퍼스 같은 좁은 공간에서 운영됩니다. 전송 속도가 빠르고 혼잡하지 않다.

2. MAN (Metropolitan Area Network): 서 울시 등 시 정도의 규모

- 대도시 지역 네트워크를 나타내며 도시 같은 넓은 지역에서 운영됩니다. 전송 속도는 평균이며 LAN보다는 더 많이 혼잡하다.

3. WAN (Wide Area Network): 세계 규모

- 광역 네트워크를 의미하며 국가 또는 대륙 같은 더 넓은 지역에서 운영됩니다. 전송 속도는 낮으며 MAN보다 더 혼잡하다.

1.5. 네트워크 성능 분석 명령어

네트워크 병목 현상의 주된 원인

• 네트워크 대역폭

• 네트워크 토폴로지

• 서버 CPU, 메모리 사용량

• 비효율적인 네트워크 구성

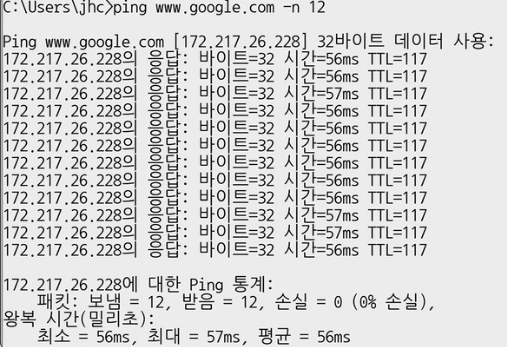

1.5.1. ping

ping(Packet INternet Groper): 대상 노드를 향해 일정 크기의 패킷을 전송하는 명령어

TCP/IP 프로토콜 중에 ICMP 프로토콜을 통해 동작.

전송 패킷수, 손실 패킷 수 및 왕복 시간의 정보를 얻을 수 있다.

1.5.2. netstat

netstat : 접속되어 있는 서비스들의 네트워크 상태를 표시하는 데 사용되며 네트워크 접속, 라우팅 테이블, 네트워크 프로토콜 등 리스트를 보여주고, 주로 서비스의 포트가 열려 있는지 확인할 때 사용한다.

1.5.3. nslookup

nslookup: DNS에 관련된 내용을 확인하기 위해 쓰는 명령어

google.com의 DNS를 확인하는 모습

1.5.4. tracert

tracert: 목적지 노드까지 네트워크 경로를 확인할 때 사용하는 명령어

어느 구간에서 응답 시간이 느려지는지 등을 확인

1.6. 네트워크 프로토콜 표준화

네트워크 프로토콜: 다른 장치들끼리 데이터를 주고 받기 위해 설정된 공통된 인터페이스(ex: http)

IEEE 또는 IETF라는 표준화 단체에서 네트워크 프로토콜을 정의

2. TCP/IP 4계층 모델

2.1. 인터넷 프로토콜 스위트(internet protocol suite)

OSI 7계층 또는 TCP/IP 계층(4계층)을 인터넷 프로토콜 스위트라고 하는데, 이는 인터넷에서 컴퓨터들이 서로 정보를 주고 받는 데 쓰이는 프로토콜의 집합이라 보면 된다. 두 집합에서 다르게 불리우는게 인터넷 계층과 네트워크 계층이다.

인터넷 프로토콜 스위트 특징: 특정 계층이 변경되었을 때 다른 계층이 영향을 받지 않도록 설계되었다.

예를 들어 전송 계층에서 TCP를 UDP로 변경했다고 해서 인터넷 웹 브라우저를 다시 설치해야 하는 것은 아니듯 유연하게 설계 된것이다.

2.1.1 애플리케이션 계층

애플리케이션(application) 계층은 FTP, HTTP, SSH, SMTP, DNS 등 응용 프로그램이 사용되는 프로토콜 계층이며 웹 서비스, 이메일 등 서비스를 실질적으로 사람들에게 제공하는 층이다.

FTP: 파일 전송 프로토콜로 서버와 클라이언트 간 파일을 전송.

SSH: 보안되지 않은 네트워크에서 네트워크 서비스를 안전하게 운영하기 위한 암호화 네트워크 프로토콜.

SMTP: 이메일 전송을 위한 프로토콜.

DNS: 도메인 이름을 IP 주소로 변환하는 시스템.

2.1.2. 전송 계층

전송(transport) 계층은 송신자와 수신자를 연결하는 통신 서비스를 제공하며 연결 지향 데이터 스트림 지원, 신뢰성, 흐름 제어를 제공하며, 애플리케이션과 인터넷 계층 사이의 데이터가 전달될 때의 중계 역할을 합니다. 예로는 TCP, UDP 등이 있으며 대표적으로 TCP와 UDP가 있습니다.

TCP: 패킷 사이의 순서를 보장하고 연결지향 프로토콜을 사용해서 연결을 하여 신뢰성을 구축해서 수신 여부를 확인하며 ‘가상회선 패킷 교환 방식’을 사용한다.

TCP의 한 패킷에는 segment라는 작은단위로 더쪼개져서 전송한다. 이때 segment를 버퍼 크기에 맞춰서 전송할 수 있다. 이때 묶인 애가 패킷이고, 이러한 방식을 stream 형식이라 한다.

UDP: 순서를 보장하지 않고 수신 여부를 확인하지 않으며 단순히 데이터만 주는 ‘데이터그램 패킷 교환 방식’을 사용한다.

2.1.2.1. 가상회선 패킷 교환 방식

가상회선 패킷 교환 방식은 각 패킷에는 가상회선 식별자가 포함되며 모든 패킷을 전송하면 가상회선이 해제되고 패킷들은 전송된 ‘순서대로’ 도착하는 방식을 의미.

3, 2, 1로 이루어진 패킷이 어떠한 회선을 따라(stream 형식) 순서대로 도착하는 것

2.1.2.2. 데이터 그램 패킷 교환 방식

데이터그램 패킷 교환 방식이란 패킷이 독립적으로 이동하며 최적의 경로를 선택하여 가는데, 하나의 메시지에서 분할된 여러 패킷은 서로 다른 경로로 전송될 수 있으며 도착한 ‘순서가 다를 수’ 있는 방식을 의미.

따로따로 이동하며 순서도 다르게 도착한다. 이는 각 패킷 앞에 헤더를 붙임으로써 목적지를 설정한다.

2.1.2.3. TCP 연결 성립 과정(Established)

앞의 그림처럼 클라이언트와 서버가 통신할 때 다음과 같은 세 단계의 과정을 거친다.

1. SYN 단계: 클라이언트는 서버에 클라이언트의 ISN(initial segment number)을 담아 SYN을 보냅니다. ISN은 새로운 TCP 연결의 첫 번째 패킷에 할당된 임의의 시퀀스 번호를 말하며(예시로 12010을 들었습니다) 이는 장치마다 다를 수 있다.

2. SYN + ACK 단계: 서버는 클라이언트의 SYN Flag를 수신하고 서버의 ISN을 보내며 승인번호로 클라이언트의 ISN + 1을 보냅니다.

3. ACK 단계: 클라이언트는 서버의 ISN + 1한 값인 승인번호를 담아 ACK를 서버에 보냅니다.

이렇게 3-웨이 핸드셰이크 과정 이후 신뢰성이 구축되고 데이터 전송을 시작합니다. 참고로 TCP는 이 과정이 있기 때문에 신뢰성이 있는 계층이라고 하며 UDP는 이 과정이 없기 때문에 신뢰성이 없는 계층이라고 한다.

2.1.2.4. TCP 연결 후 실제 데이터 전송 로직

2.1.2.5. TCP 연결 해제 과정

TCP가 연결을 해제할 때는 4-웨이 핸드셰이크(4-way handshake) 과정이 발생

1번: 먼저 클라이언트가 연결을 닫으려고 할 때 FIN으로 설정된 세그먼트를 보낸다. 그리고 클라이언트는 FIN_WAIT_1 상태로 들어가고 서버의 응답을 기다린다.

2번: 서버는 클라이언트로 ACK라는 승인 세그먼트를 보낸다. 그리고 CLOSE_WAIT 상태에 들어간다. 클라이언트는 해당 ACK 세그먼트를 받으면 FIN_WAIT_2 상태에 들어간다.

3번: 서버는 ACK를 보내고 일정 시간 이후에 클라이언트에 FIN이라는 세그먼트를 보낸다.

4번: 클라이언트는 TIME_WAIT 상태가 되고 다시 서버로 ACK를 보내서 서버는 CLOSED 상태가 된다. 이후 클라이언트는 어느 정도의 시간을 대기한 후 연결이 닫히고 클라이언트와 서버의 모든 자원의 연결이 해제된다.

TIME_WAIT

소켓이 바로 소멸되지 않고 일정 시간 유지되는 상태를 말하며 지연 패킷 등의 문제점을 해결하는 데 쓰인다. CentOS6, 우분투에는 60초로 설정되어 있으며 윈도우는 4분으로 설정되어 있다. 즉, OS마다 조금씩 다를 수 있다.

그냥 연결을 닫으면 되지 왜 굳이 일정 시간 뒤에 닫을까?

첫 번째는 지연 패킷이 발생할 경우를 대비하기 위함이다. 패킷이 뒤늦게 도달하고 이를 처리하지 못한다면 데이터 무결성 문제가 발생한다.

두 번째는 두 장치가 연결이 닫혔는지 확인하기 위해서이다. 만약 LAST_ACK 상태에서 닫히게 되면 다시 새로운 연결을 하려고 할 때 장치는 줄곧 LAST_ACK로 되어 있기 때문에 접속 오류가 나타나게 될 것이다.

이러한 이유로 TIME_WAIT라는 잠시 기다릴 시간이 필요하다.

2.1.3. 인터넷 계층

인터넷(internet) 계층은 장치로부터 받은 네트워크 패킷을 IP 주소로 지정된 목적지로 전송하기 위해 사용되는 계층이다. IP, ARP, ICMP 등이 있으며 패킷을 수신해야 할 상대의 주소를 지정하여 데이터를 전달한다. 상대방이 제대로 받았는지에 대해 보장하지 않는 비연결형적인 특징을 가지고 있다.

2.1.4. 링크 계층

전선, 광섬유, 무선 등으로 실질적으로 데이터를 전달하며 장치 간에 신호를 주고받는 ‘규칙’을 정하는 계층이다. 참고로 네트워크 접근 계층이라고도 한다.

이를 물리 계층과 데이터 링크 계층으로 나눈다.

물리 계층은 무선 LAN과 유선 LAN을 통해 0과 1로 이루어진 데이터를 보내는 계층을 말한다.

데이터 링크 계층은 ‘이더넷 프레임’을 통해 에러 확인, 흐름 제어, 접근 제어를 담당하는 계층을 말한다.

유선 LAN(IEEE802.3)

유선 LAN을 이루는 이더넷은 IEEE802.3이라는 프로토콜을 따르며 전이중화 통신을 사용한다.

전이중화 통신

전이중화(full duplex) 통신은 양쪽 장치가 동시에 송수신할 수 있는 방식이다. 이는 송신로와 수신로로 나눠서 데이터를 주고받으며 현대의 고속 이더넷은 이 방식을 기반으로 통신하고 있다.

CSMA/CD

이전에는 유선 LAN에 ‘반이중화 통신’ 중 하나인 CSMA/CD(Carrier Sense Multiple Access with Collision Detection) 방식을 썼습니다. 이 방식은 데이터를 ‘보낸 이후’ 충돌이 발생한다면 일정 시간 이후 재전송하는 방식을 말한다. 이는 수신로와 송신로를 각각 둔 것이 아니고 한 경로를 기반으로 데이터를 보내기 때문에 데이터를 보낼 때 충돌에 대해 대비해야 했기 때문이다.

유선 LAN을 이루는 케이블

유선 LAN을 이루는 케이블로는 TP 케이블이라고 하는 트위스트 페어 케이블과 광섬유 케이블이 대표적이다.

트위스트 페어 케이블

트위스트 페어 케이블(twisted pair cable)은 하나의 케이블처럼 보이지만 실제로는 여덟 개의 구리선을 두 개씩 꼬아서 묶은 케이블을 지칭한다.

케이블은 구리선을 실드 처리하지 않고 덮은 UTP 케이블과 실드 처리하고 덮은 STP로 나눠진다. 여기서 우리가 많이 볼 수 있는 케이블은 UTP 케이블로 흔히 LAN 케이블이라 한다.

무선 LAN(IEEE802.11)

무선 LAN 장치는 수신과 송신에 같은 채널을 사용하기 때문에 반이중화 통신을 사용한다.

반이중화 통신

반이중화 통신(half duplex)은 양쪽 장치는 서로 통신할 수 있지만, 동시에는 통신할 수 없으며 한 번에 한 방향만 통신할 수 있는 방식을 말한다.

일반적으로 장치가 신호를 수신하기 시작하면 응답하기 전에 전송이 완료될 때까지 기다려야 한다. 또한, 둘 이상의 장치가 동시에 전송하면 충돌이 발생하여 메시지가 손실되거나 왜곡될 수 있기 때문에 충돌 방지 시스템이 필요하다.

CSMA/CA

CSMA/CA는 반이중화 통신 중 하나로 장치에서 데이터를 보내기 전에 캐리어 감지 등으로 사전에 가능한 한 충돌을 방지하는 방식을 사용하며 과정은 다음과 같이 이루어진다.

1. 데이터를 송신하기 전에 무선 매체를 살핍니다.

2. 캐리어 감지: 회선이 비어 있는지를 판단합니다.

3. IFS(Inter FrameSpace): 랜덤 값을 기반으로 정해진 시간만큼 기다리며, 만약 무선 매체가 사용 중이면 점차 그 간격을 늘려가며 기다립니다.

4. 이후에 데이터를 송신합니다.

무선 LAN을 이루는 주파수

무선 LAN(WLAN, Wireless Local Area Network)은 무선 신호 전달 방식을 이용하여

2대 이상의 장치를 연결하는 기술

와이파이

와이파이(wifi)는 전자기기들이 무선 LAN 신호에 연결할 수 있게 하는 기술로, 이를 사용하려면 무선 접속 장치(AP, Access Point)가 있어야 한다. 흔히 이를 공유기라고 하며, 이를 통해 유선 LAN에 흐르는 신호를 무선 LAN 신호로 바꿔주어 신호가 닿는 범위 내에서 무선 인터넷을 사용할 수 있게 된다. 참고로 무선 LAN을 이용한 기술로는 와이파이만 있는 것이 아니고 지그비, 블루투스 등이 있다.

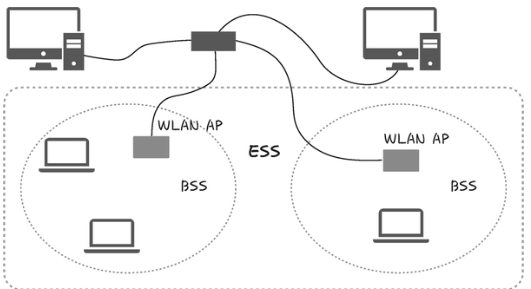

BSS

BSS(Basic Service Set)는 기본 서비스 집합을 의미하며, 단순 공유기를 통해 네트워크에 접속하는 것이 아닌 동일 BSS 내에 있는 AP들과 장치들이 서로 통신이 가능한 구조를 말한다. 근거리 무선 통신을 제공하고, 하나의 AP만을 기반으로 구축이 되어 있어 사용자가 한 곳에서 다른 곳으로 자유롭게 이동하며 네트워크에 접속하는 것은 불가능하다.

ESS

ESS(Extended Service Set)는 하나 이상의 연결된 BSS 그룹이다. 장거리 무선 통신을 제공하며 BSS보다 더 많은 가용성과 이동성을 지원한다. 즉, 사용자는 한 장소에서 다른 장소로 이동하며 중단 없이 네트워크에 계속 연결할 수 있다.

다음은 BSS와 ESS를 설명한 그림이다.

이더넷 프레임

데이터 링크 계층은 이더넷 프레임을 통해 전달받은 데이터의 에러를 검출하고 캡슐화하며 다음과 같은 구조를 가진다.

• Preamble: 이더넷 프레임이 시작임을 알립니다.

• SFD(Start Frame Delimiter): 다음 바이트부터 MAC 주소 필드가 시작됨을 알립니다.

• DMAC, SMAC: 수신, 송신 MAC 주소를 말합니다.

• EtherType: 데이터 계층 위의 계층인 IP 프로토콜을 정의합니다. 예를 들어 IPv4 또는 IPv6가 됩니다.

• Payload: 전달받은 데이터

• CRC: 에러 확인 비트

MAC 주소

컴퓨터나 노트북 등 각 장치에는 네트워크에 연결하기 위한 장치(LAN 카드)가 있는데, 이를 구별하기 위한 식별번호를 말한다.

2.2 계층간 데이터 송수신 과정

애플리케이션 계층에서 전송 계층으로 보내는 요청(request) 값들이 캡슐화 과정을 거쳐 전달되고, 다시 링크 계층을 통해 해당 서버와 통신을 하고, 해당 서버의 링크 계층으로부터 애플리케이션까지 비캡슐화 과정을 거쳐 데이터가 전송됩니다.

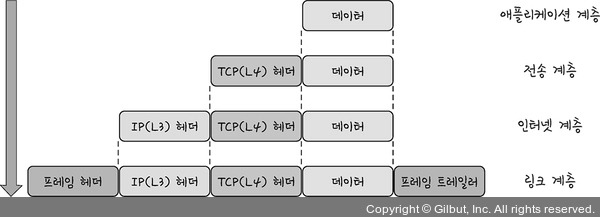

2.2.1 캡슐화 과정

캡슐화 과정은 상위 계층의 헤더와 데이터를 하위 계층의 데이터 부분에 포함시키고 해당 계층의 헤더를 삽입하는 과정이다.

▲ 그림 2-32 캡슐화 과정

애플리케이션 계층의 데이터가 전송 계층으로 전달되면서 ‘세그먼트’ 또는 ‘데이터그램’화되며 TCP(L4) 헤더가 붙여지게 된다. 그리고 이후 인터넷 계층으로 가면서 IP(L3) 헤더가 붙여지게 되며 ‘패킷’화가 되고, 이후 링크 계층으로 전달되면서 프레임 헤더와 프레임 트레일러가 붙어 ‘프레임’화가 된다. (링크계층에서 전송되는 내용물)

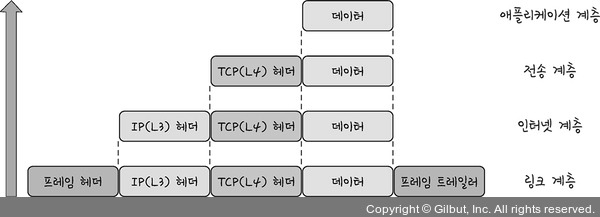

2.2.2. 비캡슐화 과정

비캡슐화 과정은 하위 계층에서 상위 계층으로 가며 각 계층의 헤더 부분을 제거하는 과정.

▲ 그림 2-33 비캡슐화 과정

이렇게 캡슐화된 데이터를 받게 되면 링크 계층에서부터 타고 올라오면서 프레임화된 데이터는 다시 패킷화를 거쳐 세그먼트, 데이터그램화를 거쳐 메시지화가 되는 비캡슐화 과정이 일어난다. 그 이후 최종적으로 사용자에게 애플리케이션의 PDU인 메시지로 전달된다.

2.3. PDU

네트워크의 어떠한 계층에서 계층으로 데이터가 전달될 때 한 덩어리의 단위를 PDU (Protocol Data Unit)라고 한다.

PDU는 제어 관련 정보들이 포함된 ‘헤더’, 데이터를 의미하는 ‘페이로드’로 구성되어 있으며 계층마다 부르는 명칭이 다르다.

• 애플리케이션 계층: 메시지

• 전송 계층: 세그먼트(TCP), 데이터그램(UDP)

• 인터넷 계층: 패킷

• 링크 계층: 프레임(데이터 링크 계층), 비트(물리 계층)

예를 들어 애플리케이션 계층은 ‘메시지’를 기반으로 데이터를 전달하는데, HTTP의 헤더가 문자열인 것을 예로 들 수 있다.

PDU 중 아래 계층인 비트로 송수신하는 것이 모든 PDU 중 가장 빠르고 효율성이 높다. 하지만 애플리케이션 계층에서는 문자열을 기반으로 송수신을 하는데, 그 이유는 개발할 시 헤더에 authorization 값(token) 등 다른 값들을 넣는 확장이 쉽기 때문이다.

3. 네트워크 기기

3.1 네트워크 기기의 처리 범위

네트워크 기기는 계층별로 처리 범위를 나눌 수 있다.

상위 계층을 처리하는 기기는 하위 계층을 처리할 수 있지만 그 반대는 불가능하다.

예를 들어 L7 스위치는 애플리케이션 계층을 처리하는 기기로, 그 밑의 모든 계층의 프로토콜을 처리할 수 있다. 하지만 AP는 물리 계층밖에 처리하지 못한다.

- 애플리케이션 계층: L7 스위치

- 인터넷 계층: 라우터, L3 스위치

- 데이터 링크 계층: 브리지, L2 스위치

- 물리 계층: NIC, 리피터, AP

3.2 애플리케이션 계층을 처리하는 기기 L7

애플리케이션 계층을 처리하는 기기로는 L7 스위치가 있다.

스위치는 여러 장비를 연결하고 데이터 통신을 중재하며 목적지가 연결된 포트로만 전기 신호를 보내 데이터를 전송하는 통신 네트워크 장비입니다.

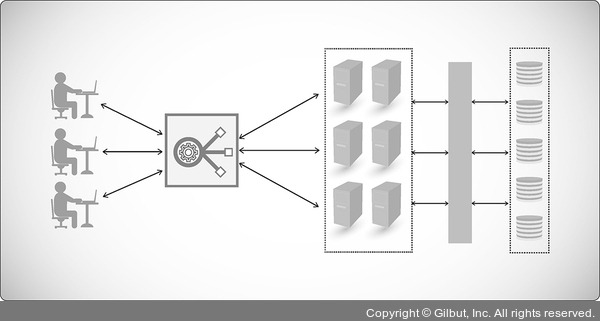

▲ 그림 2-35 L7 스위치

L7 스위치는 로드밸런서라고도 하며, 서버의 부하를 분산하는 기기이다. 클라이언트로부터 오는 요청들을 뒤쪽의 여러 서버로 나누는 역할을 하며 시스템이 처리할 수 있는 트래픽(특정 시점의 데이터 양 ) 증가를 목표로 한다.

URL, 서버, 캐시, 쿠키들을 기반으로 트래픽을 분산하며, 바이러스, 불필요한 외부 데이터 등을 걸러내는 필터링 기능 또한 가지고 있으며 응용 프로그램 수준의 트래픽 모니터링도 가능하다.

만약 장애가 발생한 서버가 있다면 이를 트래픽 분산 대상에서 제외해야 하는데, 이는 정기적으로 헬스 체크(health check)를 이용하여 감시하면서 이루어진다.

L4 스위치와 L7 스위치 차이

로드밸런서로는 L7 스위치뿐만 아니라 L4 스위치도 있다. L4 스위치는 인터넷 계층을 처리하는 기기로 스트리밍 관련 서비스에서는 사용할 수 없으며 메시지를 기반으로 인식하지 못하고 IP와 포트를 기반으로(특히 포트를 기반으로) 트래픽을 분산한다. 반면 L7 로드밸런서는 IP, 포트 외에도 URL, HTTP 헤더, 쿠키 등을 기반으로 트래픽을 분산한다.

참고로 클라우드 서비스(AWS 등)에서 L7 스위치를 이용한 로드밸런싱은 ALB (Application Load Balancer) 컴포넌트로 하며, L4 스위치를 이용한 로드밸런싱은 NLB (Network Load Balancer) 컴포넌트로 합니다.

L4, L7 스위치인 로드밸러서를 통해 서버 이중화도 가능하다. 이로인해 장애가 발생하더라도 다른 서버로 접근하게하여 서비스가 정상적으로 운영되며, 이를 통한 Blue Green 배포도 가능하다.

3.3 인터넷 계층을 처리하는 기기 L3

인터넷 계층을 처리하는 기기로는 라우터, L3 스위치가 있다.

3.3.1 라우터

라우터(router)는 여러 개의 네트워크를 연결, 분할, 구분시켜주는 역할을 하며 “다른 네트워크에 존재하는 장치끼리 서로 데이터를 주고받을 때 패킷 소모를 최소화하고 경로를 최적화하여 최소 경로로 패킷을 포워딩”하는 라우팅을 하는 장비이다.

3.3.2 L3 스위치

L3 스위치란 L2 스위치의 기능과 라우팅 기능을 갖춘 장비를 말하며, L3 스위치를 라우터라고 해도 무방합니다. 라우터는 소프트웨어 기반의 라우팅과 하드웨어 기반의 라우팅을 하는 것으로 나눠지고 하드웨어 기반의 라우팅을 담당하는 장치를 L3 스위치라고 한다.

▼ 표 2-1 L3 스위치와 L2 스위치 비교

| 구분 | L2 스위치 | L3 스위치 |

| 참조 테이블 | MAC 주소 테이블 | 라우팅 테이블 |

| 참조 PDU | 이더넷 프레임 | IP 패킷 |

| 참조 주소 | MAC 주소 | IP 주소 |

3.4 데이터 링크 계층을 처리하는 기기

데이터 링크 계층을 처리하는 기기로는 L2 스위치와 브리지가 있다.

3.4.1 L2 스위치

L2 스위치는 장치들의 MAC 주소를 MAC 주소 테이블을 통해 관리하며, 연결된 장치로부터 패킷이 왔을 때 패킷 전송을 담당합니다.

IP 주소를 이해하지 못해 IP 주소를 기반으로 라우팅은 불가능하며 단순히 패킷의 MAC 주소를 읽어 스위칭하는 역할을 한다. 목적지가 MAC 주소 테이블에 없다면 전체 포트에 전달하고 MAC 주소 테이블의 주소는 일정 시간 이후 삭제하는 기능도 있다.

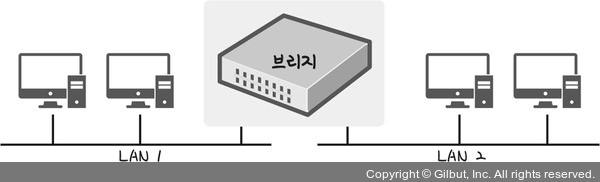

3.4.2. 브리지

브리지(bridge)는 두 개의 근거리 통신망(LAN)을 상호 접속할 수 있도록 하는 통신망 연결 장치로, 포트와 포트 사이의 다리 역할을 하며 장치에서 받아온 MAC 주소를 MAC 주소 테이블로 관리합니다.

브리지는 통신망 범위를 확장하고 서로 다른 LAN 등으로 이루어진 ‘하나의’ 통신망을 구축할 때 쓰입니다.

3.5 물리 계층을 처리하는 기기( NIC, 리피터, AP )

물리 계층을 처리하는 기기는 NIC, 리피터, AP가 있다.

NIC

LAN 카드라고 하는 네트워크 인터페이스 카드(NIC, Network Interface Card)는 2대 이상의 컴퓨터 네트워크를 구성하는 데 사용하며, 네트워크와 빠른 속도로 데이터를 송수신할 수 있도록 컴퓨터 내에 설치하는 확장 카드이다.

각 LAN 카드에는 주민등록번호처럼 각각을 구분하기 위한 고유의 식별번호인 MAC 주소가 있다.

리피터

리피터(repeater)는 들어오는 약해진 신호 정도를 증폭하여 다른 쪽으로 전달하는 장치를 말한다.

이를 통해 패킷이 더 멀리 갈 수 있다. 하지만 이는 광케이블이 보급됨에 따라 현재는 잘 쓰이지 않는 장치이다.

AP

AP(Access Point)는 패킷을 복사하는 기기이다. 즉, AP에 유선 LAN을 연결한 후 다른 장치에서 무선 LAN 기술(와이파이 등)을 사용하여 무선 네트워크 연결을 할 수 있다.

4. IP 주소

4.1 ARP

컴퓨터와 컴퓨터 간의 통신은 흔히들 IP 주소 기반으로 통신한다고 알고 있지만 정확히 이야기하자면 IP 주소에서 ARP를 통해 MAC 주소를 찾아 MAC 주소를 기반으로 통신한다.

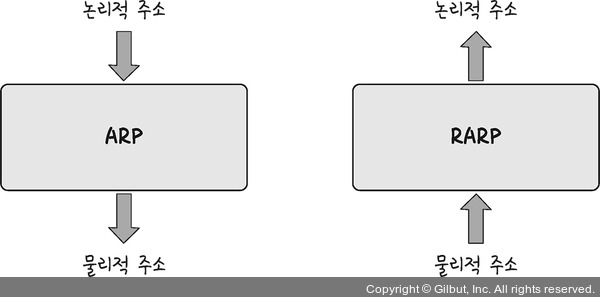

ARP(Address Resolution Protocol)란 IP 주소로부터 MAC 주소를 구하는 IP와 MAC 주소의 다리 역할을 하는 프로토콜이다.

ARP를 통해 가상 주소인 IP 주소를 실제 주소인 MAC 주소로 변환한다. 이와 반대로 RARP를 통해 실제 주소인 MAC 주소를 가상 주소인 IP 주소로 변환하기도 합니다.

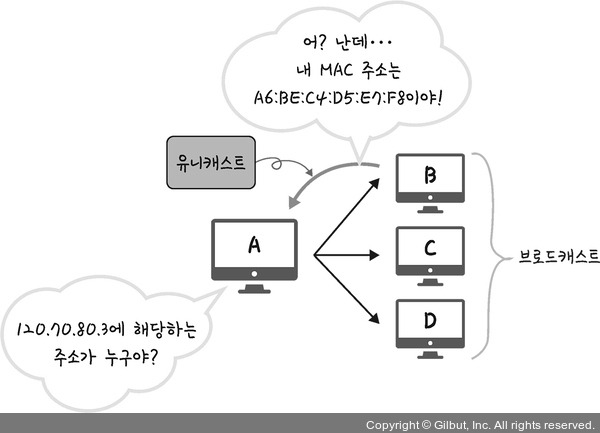

1. 장치 A가 ARP Request 브로드캐스트 (1:n 통신)를 보내서 IP 주소인 120.70.80.3에 해당하는 MAC 주소가 누구인지 통신.

2. 해당 주소에 맞는 장치 B가 ‘ARP reply 유니캐스트(1:1 통신)’를 통해 MAC 주소를 반환하는 과정을 거쳐 IP 주소에 맞는 MAC 주소를 찾게 된다.

4.2 홉바이홉 통신

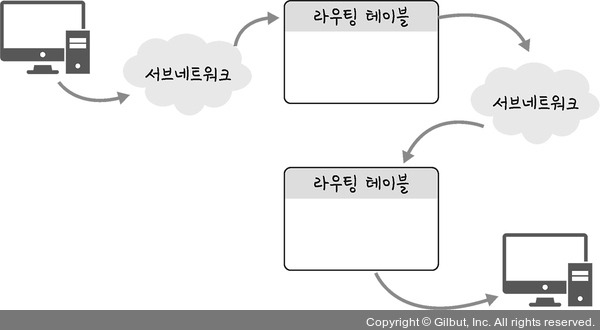

IP 주소를 통해 통신하는 과정을 홉바이홉(hop by hop) 통신이라고 한다.

여기서 홉(hop)이란 영어 뜻 자체로는 건너뛰는 모습을 의미하는데, 통신망에서 각 패킷이 여러 개의 라우터를 건너가는 모습을 비유적으로 표현한 것이다. 각각의 라우터에 있는 라우팅 테이블의 IP를 기반으로 패킷을 전달하고 다시 전달해나간다.

즉, 통신 장치에 있는 ‘라우팅 테이블’의 IP를 통해 시작 주소부터 시작하여 다음 IP로 계속해서 이동하는 ‘라우팅’ 과정을 거쳐 패킷이 최종 목적지까지 도달하는 통신을 말한다.

2.4.1. 라우팅 테이블

라우팅 테이블(routing table)은 송신지에서 수신지까지 도달하기 위해 사용되며 라우터에 들어가 있는 목적지 정보들과 그 목적지로 가기 위한 방법이 들어 있는 리스트를 뜻한다. 라우팅 테이블에는 게이트웨이와 모든 목적지에 대해 해당 목적지에 도달하기 위해 거쳐야 할 다음 라우터의 정보를 가지고 있다.

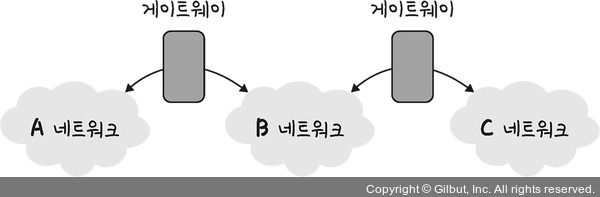

2.4.2. 게이트웨이

게이트웨이(gateway)는 서로 다른 통신망, 프로토콜을 사용하는 네트워크 간의 통신을 가능하게 하는 관문 역할을 하는 컴퓨터나 소프트웨어를 두루 일컫는 용어이다.

사용자는 인터넷에 접속하기 위해 수많은 톨게이트인 게이트웨이를 거쳐야 하며 게이트웨이는 서로 다른 네트워크상의 통신 프로토콜을 변환해주는 역할을 하기도 한다.

2.4.3. 라우팅 테이블 확인 명령어 netstat -r

4.3 IP 주소 체계

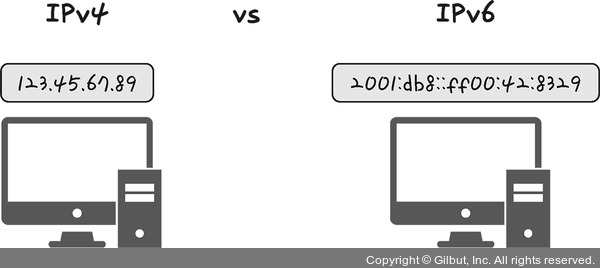

IP 주소는 IPv4와 IPv6로 나뉜다. IPv4는 32비트를 8비트 단위로 점을 찍어 표기하며, 123.45.67.89 같은 방식으로 IP 주소를 나타낸다. IPv6는 64비트를 16비트 단위로 점을 찍어 표기하며, 2001:db8::ff00:42:8329 같은 방식으로 IP 주소를 나타낸다.

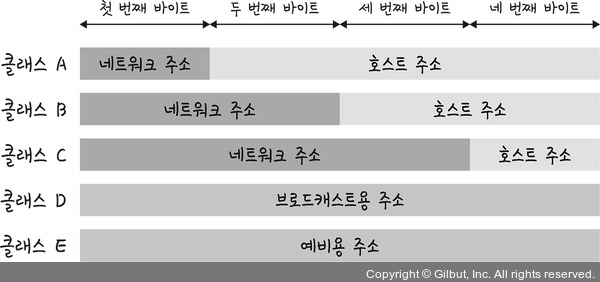

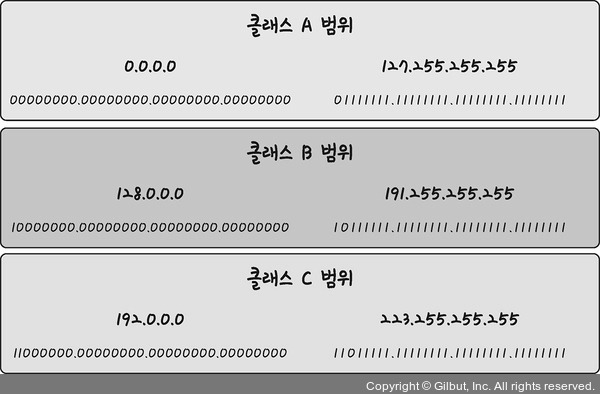

4.3.1 클래스 기반 할당 방식

클래스 A·B·C는 일대일 통신으로 사용되고 클래스 D는 멀티캐스트 통신, 클래스 E는 앞으로 사용할 예비용으로 쓰는 방식이다. 예를 들어 클래스 A의 경우 0.0.0.0부터 127.255.255.255까지 범위를 갖는다.

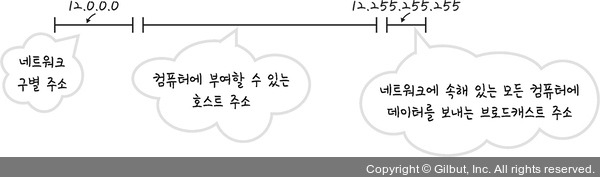

또한, 네트워크의 첫 번째 주소는 네트워크 주소로 사용되고 가장 마지막 주소는 브로드캐스트용 주소로 네트워크에 속해 있는 모든 컴퓨터에 데이터를 보낼 때 사용된다.

예를 들어 클래스 A로 12.0.0.0이란 네트워크를 부여받았다고 해보자. 그렇다면 12.0.0.1~12.255.255.254의 호스트 주소를 부여받은 것이다. 이때 첫 번째 주소인 12.0.0.0은 네트워크 구별 주소로 사용하면 안되고 가장 마지막 주소인 12.255.255.255의 경우 브로드캐스트용으로 남겨두어야 하니 이 또한 사용하면 안된다. 그렇기 때문에 그 사이에 있는 12.0.0.1~12.255.255.254를 컴퓨터에 부여할 수 있는 호스트 주소로 사용할 수 있다.

하지만 이 방식은 사용하는 주소보다 버리는 주소가 많은 단점이 있었고 이를 해소하기 위해 DHCP와 IPv6, NAT가 나온다.

4.3.2 DHCP

DHCP(Dynamic Host Configuration Protocol)는 IP 주소 및 기타 통신 매개변수를 자동으로 할당하기 위한 네트워크 관리 프로토콜이다. 이 기술을 통해 네트워크 장치의 IP 주소를 수동으로 설정할 필요 없이 인터넷에 접속할 때마다 자동으로 IP 주소를 할당할 수 있다.

많은 라우터와 게이트웨이 장비에 DHCP 기능이 있으며 이를 통해 대부분의 가정용 네트워크에서 IP 주소를 할당한다.

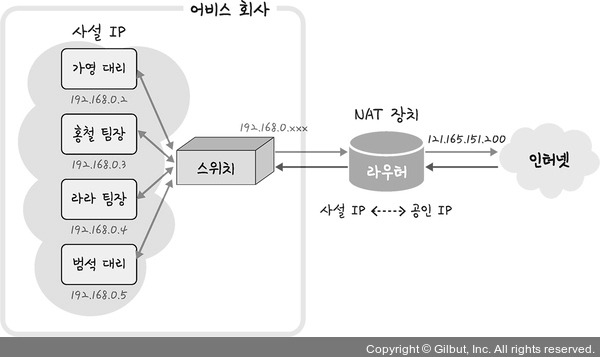

4.3.3 NAT

NAT(Network Address Translation)는 패킷이 라우팅 장치를 통해 전송되는 동안 패킷의 IP 주소 정보를 수정하여 IP 주소를 다른 주소로 매핑하는 방법이다. IPv4 주소 체계만으로는 많은 주소들을 모두 감당하지 못하는 단점이 있는데, 이를 해결하기 위해 NAT로 공인 IP와 사설 IP로 나눠서 많은 주소를 처리한다. NAT를 가능하게 하는 소프트웨어는 ICS, RRAS, Netfilter 등이 있다.

공유기와 NAT

NAT를 쓰는 이유는 주로 여러 대의 호스트가 하나의 공인 IP 주소를 사용하여 인터넷에 접속하기 위함입니다. 예를 들어 인터넷 회선 하나를 개통하고 인터넷 공유기를 달아서 여러 PC를 연결하여 사용할 수 있는데, 이것이 가능한 이유는 인터넷 공유기에 NAT 기능이 탑재되어 있기 때문이다.

NAT를 이용한 보안

NAT를 이용하면 내부 네트워크에서 사용하는 IP 주소와 외부에 드러나는 IP 주소를 다르게 유지할 수 있기 때문에 내부 네트워크에 대한 어느 정도의 보안이 가능해진다.

NAT의 단점

NAT는 여러 명이 동시에 인터넷을 접속하게 되므로 실제로 접속하는 호스트 숫자에 따라서 접속 속도가 느려질 수 있다는 단점이 있다.

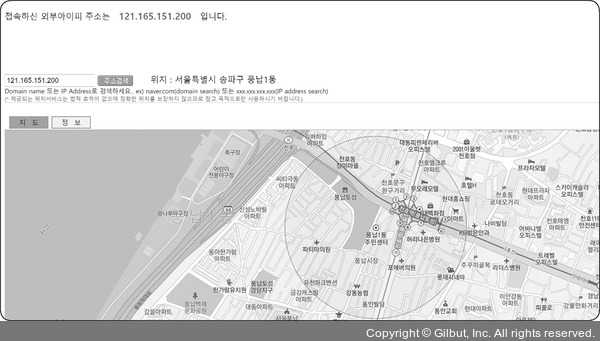

4.4 IP 주소를 이용한 위치 정보

IP 주소는 인터넷에서 사용하는 네트워크 주소이기 때문에 이를 통해 동 또는 구까지 위치 추적이 가능하다.

• mylocation 사이트 링크: https://mylocation.co.kr/

5. HTTP

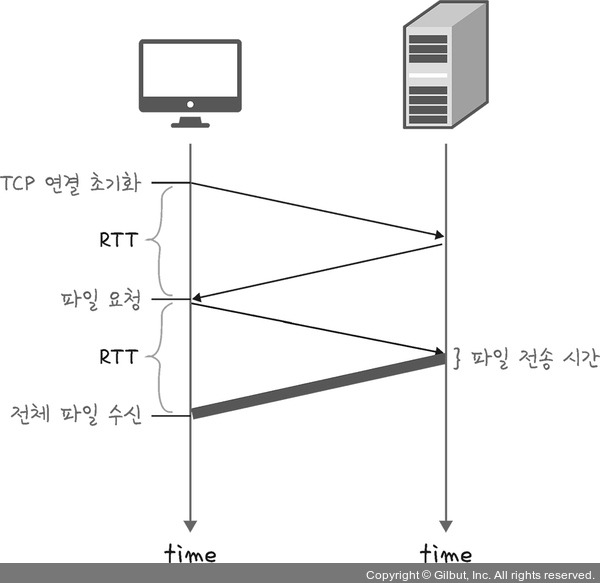

5.1 HTTP/1.0

HTTP/1.0은 기본적으로 한 연결당 하나의 요청을 처리하도록 설계되어 RTT 증가를 초래한다.

RTT 증가

서버로부터 파일을 가져올 때마다 TCP의 3-웨이 핸드셰이크를 계속해서 열어야 하기 때문에 RTT가 증가하는 단점이 있었다.

RTT: 패킷이 목적지에 도달하고 나서 다시 출발지로 돌아오기까지 걸리는 시간이며 패킷 왕복 시간

이미지 스플리팅: 많은 이미지를 다운로드받게 되면 과부하가 걸리기 때문에 많은 이미지가 합쳐 있는 하나의 이미지를 다운로드받고, 이를 기반으로 background-image의 position을 이용하여 이미지를 표기하는 방법

응답 시간 증가의 문제점을 해결하기 위해 이미지 스플리팅, 코드 압축, 이미지 Base64 인코딩 등의 방법을 사용했다.

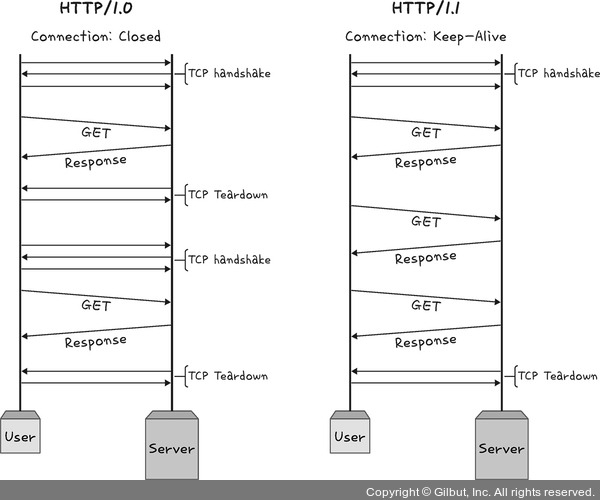

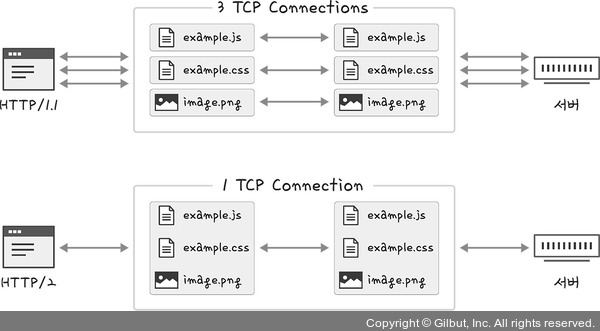

5.2 HTTP/1.1

매번 TCP 연결을 하는 것이 아니라 한 번 TCP 초기화를 한 이후에 keep-alive라는 옵션으로 여러 개의 파일을 송수신할 수 있게 바뀌었다.

한번 TCP 3-웨이 핸드셰이크가 발생하면 그다음부터 발생하지 않는다. 하지만 문서 안에 포함된 다수의 리소스(이미지, css 파일, script 파일)를 처리하려면 요청할 리소스 개수에 비례해서 대기 시간이 길어지는 단점이 있다.

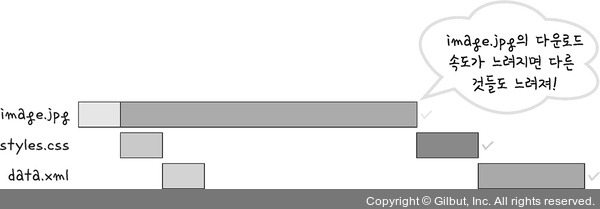

5.2.1 HOL Blocking

HOL Blocking(Head Of Line Blocking)은 네트워크에서 같은 큐에 있는 패킷이 그 첫 번째 패킷에 의해 지연될 때 발생하는 성능 저하 현상이다.

▲ 그림 2-56 HOL Blocking

예를 들어 앞의 그림처럼 image.jpg와 styles.css, data.xml을 다운로드받을 때 보통은 순차적으로 잘 받아지지만 image.jpg가 느리게 받아진다면 그 뒤에 있는 것들이 대기하게 되며 다운로드가 지연되는 상태가 된다.

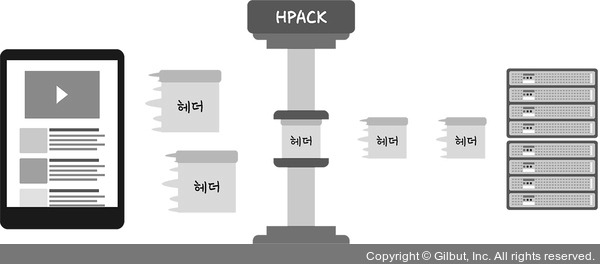

HTTP/1.1의 헤더에는 쿠키 등 많은 메타데이터가 들어 있고 압축이 되지 않아 무거웠다.

5.3 HTTP/2

HTTP/2는 SPDY 프로토콜에서 파생된 HTTP/1.x보다 지연 시간을 줄이고 응답 시간을 더 빠르게 할 수 있으며 멀티플렉싱, 헤더 압축, 서버 푸시, 요청의 우선순위 처리를 지원하는 프로토콜이다.

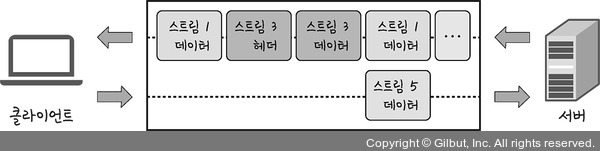

5.3.1 멀티플렉싱

멀티플렉싱이란 여러 개의 스트림을 사용하여 송수신하는 것. 이를 통해 특정 스트림의 패킷이 손실되었다고 하더라도 해당 스트림에만 영향을 미치고 나머지 스트림은 멀쩡하게 동작할 수 있다.

병렬적인 스트림(stream) 들을 통해 데이터를 서빙하고, 스트림 내의 데이터들도 쪼개져 있다. 애플리케이션에서 받아온 메시지를 독립된 프레임으로 조각내어 서로 송수신한 이후 다시 조립하며 데이터를 주고받는다.

이를 통해 단일 연결을 사용하여 병렬로 여러 요청을 받을 수 있고 응답을 줄 수 있다. 이렇게 되면 HTTP/1.x에서 발생하는 문제인 HOL Blocking을 해결할 수 있다.

이를 HTTP/2에서는 헤더 압축을 써서 해결하는데, 허프만 코딩 압축 알고리즘을 사용하는 HPACK 압축 형식을 가집니다.

5.3.2 허프만 코딩

허프만 코딩(huffman coding)은 문자열을 문자 단위로 쪼개 빈도수를 세어 빈도가 높은 정보는 적은 비트 수를 사용하여 표현하고, 빈도가 낮은 정보는 비트 수를 많이 사용하여 표현해서 전체 데이터의 표현에 필요한 비트양을 줄이는 원리입니다.

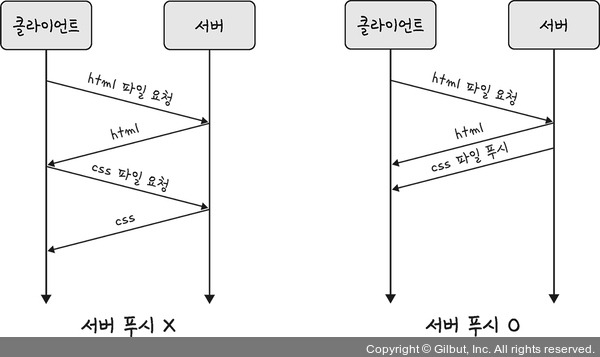

5.3.3 서버 푸시

HTTP/1.1에서는 클라이언트가 서버에 요청을 해야 파일을 다운로드받을 수 있었다면, HTTP/2는 클라이언트 요청 없이 서버가 바로 리소스를 푸시할 수 있다.

html에는 css나 js 파일이 포함되기 마련인데 html을 읽으면서 그 안에 들어 있던 css 파일을 서버에서 푸시하여 클라이언트에 먼저 줄 수 있다.

5.4 HTTPS

HTTP/2는 HTTPS 위에서 동작하며, HTTPS는 애플리케이션 계층과 전송 계층 사이에 신뢰 계층인 SSL/TLS 계층을 넣은 신뢰할 수 있는 HTTP 요청을 말한다. 이를 통해 ‘통신을 암호화’한다.

5.4.1. SSL/TLS

SSL(Secure Socket Layer)은 SSL 1.0부터 시작해서 SSL 2.0, SSL 3.0, TLS(Transport Layer Security Protocol) 1.0, TLS 1.3까지 버전이 올라가며 마지막으로 TLS로 명칭이 변경되었으나, 보통 이를 합쳐 SSL/TLS로 많이 부른다.

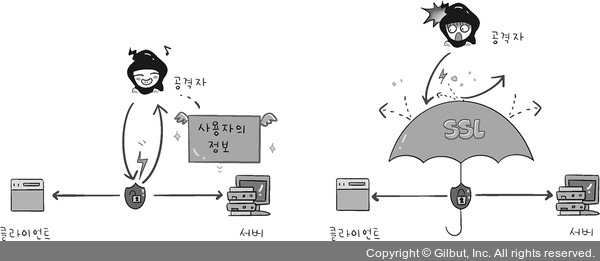

SSL/TLS은 전송 계층에서 보안을 제공하는 프로토콜이다. 클라이언트와 서버가 통신할 때 SSL/TLS를 통해 제3자가 메시지를 도청하거나 변조하지 못하도록 한다.

앞의 그림처럼 SSL/TLS를 통해 공격자가 서버인 척하며 사용자 정보를 가로채는 네트워크상의 ‘인터셉터’를 방지할 수 있다.

SSL/TLS는 보안 세션을 기반으로 데이터를 암호화하며 보안 세션이 만들어질 때 인증 메커니즘, 키 교환 암호화 알고리즘, 해싱 알고리즘이 사용.

5.4.2. 보안 세션

보안 세션이란 보안이 시작되고 끝나는 동안 유지되는 세션을 말하고, SSL/TLS는 핸드셰이크를 통해 보안 세션을 생성하고 이를 기반으로 상태 정보 등을 공유한다.

세션: 운영체제가 어떠한 사용자로부터 자신의 자산 이용을 허락하는 일정한 기간을 뜻한다. 즉, 사용자는 일정 시간 동안 응용 프로그램, 자원 등을 사용할 수 있다.

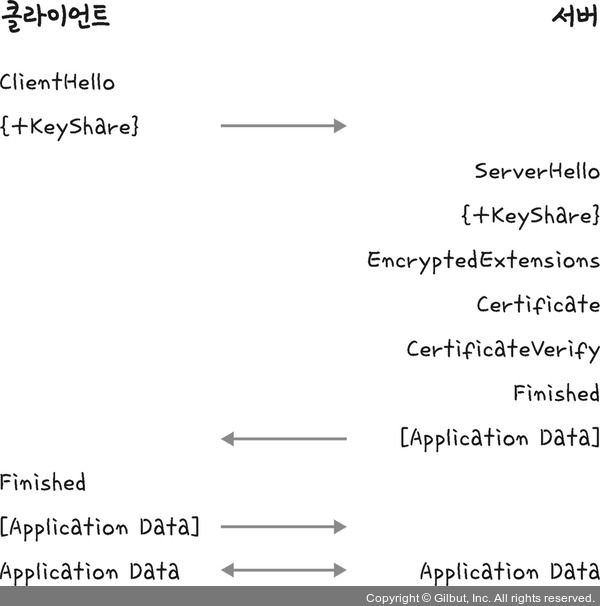

TLS 핸드셰이크 동작

- 핸드셰이크는 클라이언트와 서버가 키를 공유하고 이를 기반으로 인증 및 데이터 암호화를 설정하는 과정이다.

- 클라이언트가 사이퍼 슈트(cypher suites)를 서버에 전달하면, 서버는 해당 암호화 알고리즘 중 하나를 선택하여 인증 과정을 시작한다.

- 서버는 인증서를 클라이언트에 제공하고, 클라이언트는 이를 검증한 후 키 교환을 통해 암호화 통신을 준비한다.

- 이후, 해싱 알고리즘을 포함한 암호화된 데이터 송수신이 시작된다.

사이퍼 슈트

- 사이퍼 슈트는 프로토콜, AEAD 사이퍼 모드, 해싱 알고리즘을 규정한 규약이다.

- 예시는 아래와 같다:

- TLS_AES_128_GCM_SHA256

- TLS: 프로토콜

- AES_128_GCM: AEAD 사이퍼 모드

- SHA256: 해싱 알고리즘

- TLS_AES_128_GCM_SHA256

AEAD 사이퍼 모드

- AEAD(Authenticated Encryption with Associated Data)는 데이터를 암호화하고 인증하는 알고리즘이다.

- AES_128_GCM은 128비트 키를 사용하는 AES 암호화 방식과 병렬 처리에 적합한 GCM 알고리즘을 결합한 것이다.

인증 메커니즘

- CA(Certificate Authority)에서 발급한 인증서를 통해 서버의 신뢰성을 검증한다.

- CA 인증서는 공개키를 포함하며, 서버가 신뢰할 수 있는 대상임을 보장한다.

- 인증서는 서비스 정보, 공개키, 지문(fingerprint), 디지털 서명으로 구성된다.

CA 발급 과정

- 서비스는 공개키와 사이트 정보를 CA에 제출한다.

- CA는 제출된 정보를 검증한 후 CA의 비밀키로 서명하여 인증서를 발급한다.

용어

- 개인키: 비밀 키이며, 소유자만이 알고 있어야 한다.

- 공개키: 누구나 볼 수 있는 키이며, 개인키와 쌍으로 작동한다.

암호화 알고리즘

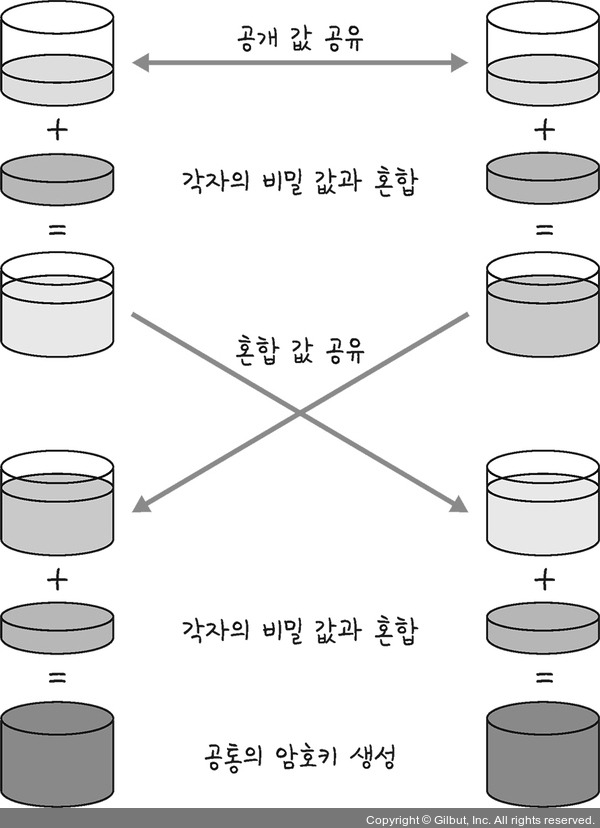

키 교환 암호화 알고리즘으로는 대수곡선 기반의 ECDHE(Elliptic Curve Diffie-Hellman Ephermeral) 또는 모듈식 기반의 DHE(Diffie-Hellman Ephermeral)를 사용한다. 둘 다 디피-헬만(Diffie-Hellman) 방식을 근간으로 만들어졌습니다.

디피-헬만 키 교환 암호화 알고리즘

디피-헬만 키 교환(Diffie-Hellman key exchange) 암호화 알고리즘은 암호키를 교환하는 하나의 방법이다.

앞의 식에서 g와 x와 p를 안다면 y는 구하기 쉽지만 g와 y와 p만 안다면 x를 구하기는 어렵다는 원리에 기반한 알고리즘입니다.

▲ 그림 2-63 디피-헬만 키 교환 암호화 알고리즘

앞의 그림처럼 처음에 공개 값을 공유하고 각자의 비밀 값과 혼합한 후 혼합 값을 공유한다. 그다음 각자의 비밀 값과 또 혼합합니다. 그 이후에 공통의 암호키가 생성되는 것이다.

이렇게 클라이언트와 서버 모두 개인키와 공개키를 생성하고 서로에게 공개키를 보내고 공개키와 개인키를 결합하여 PSK(사전 합의된 비밀키)가 생성된다면, 악의적인 공격자가 개인키 또는 공개키를 가지고도 PSK가 없기 때문에 아무것도 할 수 없다. 이를 통해 키를 암호화할 수 있는 것이다.

해싱 알고리즘

해싱 알고리즘은 데이터를 추정하기 힘든 더 작고, 섞여 있는 조각으로 만드는 알고리즘이다. SSL/TLS는 해싱 알고리즘으로 SHA-256 알고리즘과 SHA-384 알고리즘을 쓴다.

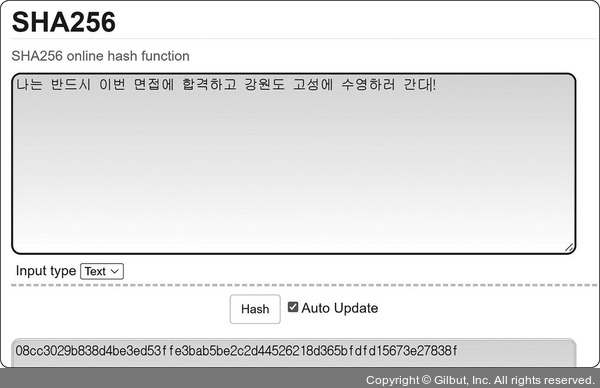

SHA-256 알고리즘

SHA-256 알고리즘은 해시 함수의 결괏값이 256비트인 알고리즘이며 비트 코인을 비롯한 많은 블록체인 시스템에서도 쓴다. SHA-256 알고리즘은 해싱을 해야 할 메시지에 1을 추가하는 등 전처리를 하고 전처리된 메시지를 기반으로 해시를 반환한다.

앞의 그림처럼 “나는 반드시 이번 면접에 합격하고 강원도 고성에 수영하러 간다!”라는 글자가 08cc3029b838d4be3ed53ffe3bab5be2c2d44526218d365bfdfd15673e27838f라는 도무지 무슨 뜻인지 알아들을 수 없는 문자열로 변환되는 것을 볼 수 있다.

해시

다양한 길이를 가진 데이터를 고정된 길이를 가진 데이터로 매핑(mapping)한 값

해싱

임의의 데이터를 해시로 바꿔주는 일이며 해시 함수가 이를 담당

해시 함수

임의의 데이터를 입력으로 받아 일정한 길이의 데이터로 바꿔주는 함수

TLS 1.3은 사용자가 이전에 방문한 사이트로 다시 방문한다면 SSL/TLS에서 보안 세션을 만들 때 걸리는 통신을 하지 않아도 된다. 이를 0-RTT라고 한다.

SEO에도 도움이 되는 HTTPS

구글(Google)은 SSL 인증서를 강조해왔고 사이트 내 모든 요소가 동일하다면 HTTPS 서비스를 하는 사이트가 그렇지 않은 사이트보다 SEO 순위가 높을 것이라고 공식적으로 밝혔다.

SEO(Search Engine Optimization)는 검색엔진 최적화를 뜻하며 사용자들이 구글, 네이버 같은 검색엔진으로 웹 사이트를 검색했을 때 그 결과를 페이지 상단에 노출시켜 많은 사람이 볼 수 있도록 최적화하는 방법을 의미.

5.4.3. HTTPS 구축 방법(3가지)

1. 직접 CA에서 구매한 인증키를 기반으로 HTTPS 서비스를 구축

2. 서버 앞단의 HTTPS를 제공하는 로드밸런서

3. 서버 앞단에 HTTPS를 제공하는 CDN을 둬서 구축

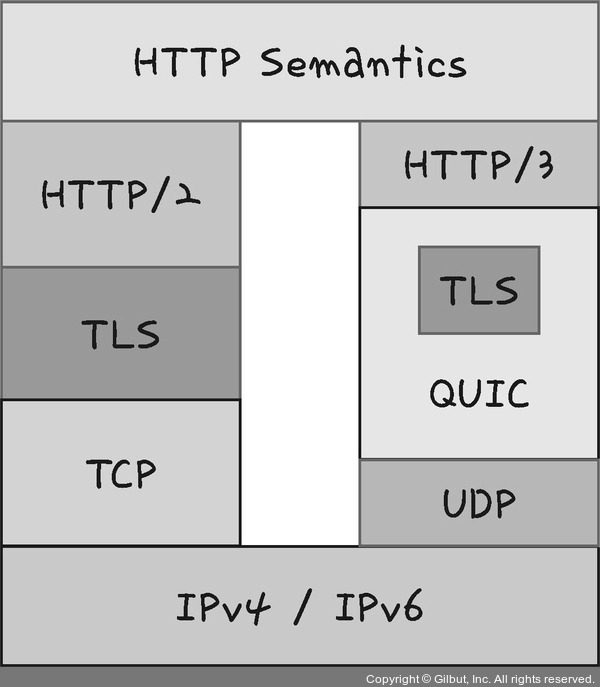

5.5 HTTP/3

HTTP/3은 HTTP/1.1 및 HTTP/2와 함께 World Wide Web에서 정보를 교환하는 데 사용되는 HTTP의 세 번째 버전이다. TCP 위에서 돌아가는 HTTP/2와는 달리 HTTP/3은 QUIC이라는 계층 위에서 돌아가며, TCP 기반이 아닌 UDP 기반으로 돌아간다.

▲ 그림 2-68 UDP 기반으로 돌아가는 HTTP/3

또한, HTTP/2에서 장점이었던 멀티플렉싱을 가지고 있으며 초기 연결 설정 시 지연 시간 감소라는 장점이 있다.

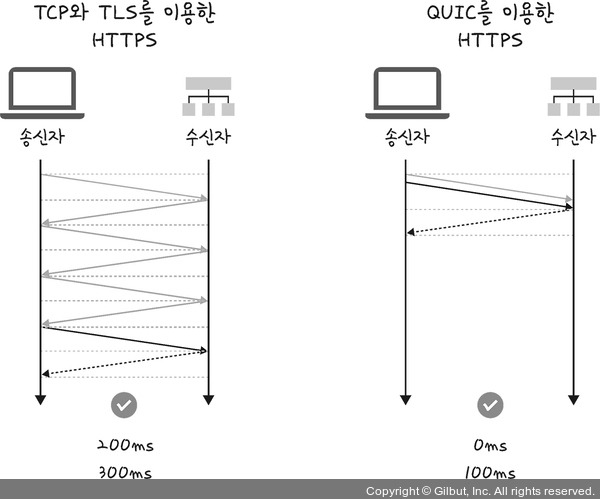

5.5.1 초기 연결 설정 시 지연 시간 감소

QUIC은 TCP를 사용하지 않기 때문에 통신을 시작할 때 번거로운 3-웨이 핸드셰이크 과정을 거치지 않아도 된다.

UDP 위에서 TCP와 비슷한 기능인 연결 설정, 흐름 제어, 혼잡 제어를 프로토콜 수준에서 구현하고, QUIC은 TLS 1.3을 프로토콜에 내장하여 보안 연결 설정 속도를 크게 향상한 새로운 전송계층의 프로토콜이다.

QUIC은 첫 연결 설정에 1-RTT만 소요되며 . 클라이언트가 서버에 어떤 신호를 한 번 주고, 서버도 거기에 응답하기만 하면 바로 본 통신을 시작할 수 있다는 것이다.

참고로 QUIC은 순방향 오류 수정 메커니즘(FEC, Forword Error Correction)이 적용되었다. 이는 전송한 패킷이 손실되었다면 수신 측에서 에러를 검출하고 수정하는 방식이며 열악한 네트워크 환경에서도 낮은 패킷 손실률을 자랑한다.

'CS스터디' 카테고리의 다른 글

| [면접을 위한 CS 전공 지식 노트] 5장 자료구조 (0) | 2025.01.20 |

|---|---|

| [면접을 위한 CS 전공 지식 노트] 3장 운영체제 (0) | 2025.01.07 |

| [면접을 위한 CS 전공 지식 노트] 1장 디자인 패턴: 프로그래밍과 패러다임[2] (0) | 2024.05.18 |

| [면접을 위한 CS 전공 지식 노트] 1장 디자인 패턴: 디자인 패턴[1] (0) | 2024.05.18 |